자율주행 자동차를 위한 센서

- 여기에서 소개하는 센서는 실제 자율주행 자동차에서 중요하게 사용되는 센서들이지만 본 실습에서는 카메라 센서를 중심으로 진행함

1. 센서의 종류와 역할

1.1 카메라(Camera) 센서

(사진출처: 디바이스마트)

- 역할과 특징

- 자율주행차의 ‘눈’ 역할을 담당함

- 실제 사람이 보는 것과 가장 유사한 시각적 정보 제공

- 차선, 교통 표지판, 신호등, 보행자, 다른 차량 등의 식별에 사용

- 카메라 센서의 종류

- RGB 카메라: 색상 정보를 포함한 풍부한 시각 정보 제공

- 스테레오 카메라: 두 개의 렌즈를 통해 깊이 정보까지 측정

- 자율주행차의 ‘눈’ 역할을 담당함

- 장점

- 고해상도 이미지로 물체의 색상, 형태, 텍스처 등 상세한 시각 정보 획득 가능

- 비교적 저렴한 가격과 작은 크기로 다양한 위치에 설치 가능

- 신호등, 도로 표지판 등 색상 기반 정보 인식에 탁월

- 한계

- 악천후(비, 눈, 안개) 및 야간 환경에서 성능 저하

- 2D 이미지만으로는 정확한 거리 측정이 어려움 (스테레오 카메라로 일부 보완 가능)

- 빛 조건에 민감하게 반응함

1.2 라이다(LiDAR) 센서

- LiDAR: Light Detection And Ranging

(사진출처: 디바이스마트)

- 역할과 특징

- 레이저 펄스를 발사하고 반사되어 돌아오는 시간을 측정하여 주변 환경의 정밀한 3D 맵 생성

- 수백만 개의 포인트 클라우드(Point Cloud)를 생성하여 주변 물체의 정확한 형태와 거리 파악

- 라이다 센서의 유형

- 기계식 라이다: 360도 회전하며 주변 환경을 스캔

- 고정식 솔리드 스테이트 라이다

- 장점

- 매우 정확한 거리 측정 및 3D 공간 인식 가능

- 빛의 조건에 상관없이 주야간 안정적인 성능 발휘

- 넓은 시야각(최대 360도)으로 차량 주변 전체 환경 스캔 가능

- 한계

- 상대적으로 고가의 장비로 비용 부담이 큼

- 강한 비나 눈, 안개 등 악천후 조건에서 성능 저하 가능

- 색상 정보를 제공하지 않아 교통 신호 등의 인식에는 카메라와 병행 필요

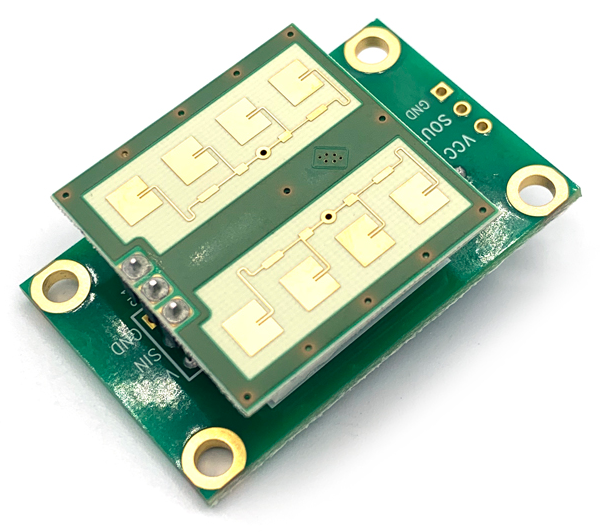

1.3 레이더(Radar) 센서

- Radar: Radio Detection And Ranging

(사진출처: 디바이스마트)

- 역할과 특징

- 전파(라디오파)를 발사하고 물체에 반사되어 돌아오는 신호를 분석하여 거리, 속도, 방향 측정

- 주로 전방 충돌 방지, 적응형 크루즈 컨트롤, 사각지대 감지 등에 활용

- 단거리(SRR), 중거리(MRR), 장거리(LRR) 레이더 등 다양한 유형

- 장점

- 악천후(비, 눈, 안개) 및 열악한 조명 조건에서도 안정적인 성능 발휘

- 물체의 상대 속도를 직접 측정할 수 있어 움직이는 물체 추적에 효과적

- 비교적 저렴한 가격과 긴 수명으로 경제성 우수

- 한계

- 라이다에 비해 낮은 해상도로 물체의 정확한 형태 파악이 어려움

- 금속 물체는 잘 감지하지만 플라스틱이나 나무와 같은 비금속 물체 감지에 한계

- 근거리에서의 정확도가 상대적으로 낮음

1.4 초음파(Ultrasonic) 센서

(사진출처: 디바이스마트)

- 역할과 특징

- 초음파를 발사하고 반사되어 돌아오는 시간을 측정하여 근거리 물체와의 거리 파악

- 주로 주차 보조, 저속 주행 시 장애물 감지 등 근거리 상황에서 활용

- 차량의 범퍼나 측면에 여러 개가 설치되어 근접한 장애물 감지

- 장점

- 매우 저렴한 비용으로 구현 가능

- 날씨나 조명 조건에 영향을 거의 받지 않음

- 근거리 물체 감지에 매우 정확하고 신뢰성 높음

- 한계

- 매우 제한된 감지 거리(일반적으로 0.2~5m)

- 낮은 해상도로 물체의 형태나 종류 식별 불가

- 소프트 타겟(예: 눈, 천 등)에 대한 감지 성능 떨어짐

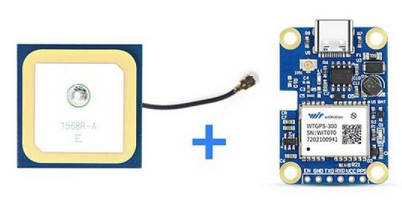

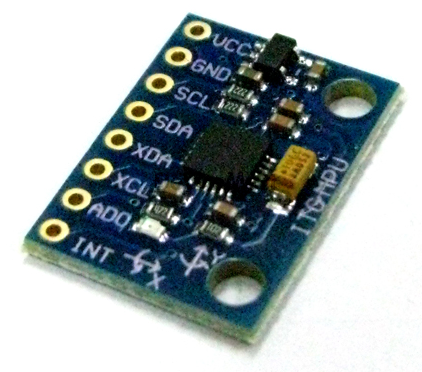

1.5 GPS/GNSS 및 IMU 센서

- GPS: Global Positioning System(위성항법시스템, 미국)

- GNSS: Global Navigation Satellite System(위성항법시스템, 각국)

- KPS: Korean Positioning System(한국위성항법시스템)

- IMU: Inertial Measurement Unit(관성 측정 장치)

(사진출처: 디바이스마트)

- 역할과 특징

- GPS/GNSS: 위성 신호를 통해 차량의 절대 위치 파악

- IMU는 가속도계와 자이로스코프를 통해 차량의 움직임, 방향, 기울기 등 측정

- 두 센서의 데이터를 융합하여 차량의 정확한 위치와 자세 추정

- 장점

- 넓은 지역에서의 위치 파악 및 경로 계획에 필수적

- GPS와 IMU 데이터 융합을 통해 위치 정확도 향상

- 자율주행차의 전역 위치 결정에 기준점 제공

- 한계

- GPS는 터널, 고층 건물 사이 등 위성 신호가 차단되는 곳에서 정확도 저하

- 일반 GPS의 오차 범위(수 미터)는 자율주행에 충분히 정밀하지 않음 (RTK-GPS로 보완)

- IMU는 시간이 지남에 따라 오차가 누적되는 특성이 있음

1.6 V2X 통신 시스템

V2X: Vehicle-to-Everything

- 역할과 특징

- 차량이 다른 차량(V2V), 인프라(V2I), 보행자(V2P), 네트워크(V2N) 등과 통신하여 정보 교환

- 시야 밖의 위험 요소나 교통 상황 정보의 사전 획득 가능

- DSRC(Dedicated Short Range Communications) 또는 C-V2X(Cellular V2X) 기술 사용

- 장점

- 센서가 직접 감지할 수 없는 정보(교차로 너머의 차량, 전방 교통 체증 등) 획득 가능

- 다른 차량 및 인프라와의 협력 주행을 통한 안전성 및 효율성 향상

- 실시간 교통 정보 및 위험 상황 경고 공유 가능

- 한계

- 통신 인프라가 구축된 지역에서만 활용 가능

- 모든 차량이 V2X 기능을 갖추고 있어야 효과 극대화

- 사이버 보안 위협에 대한 취약성 존재

1.7. 열화상 카메라(Thermal Camera)

(사진출처: GMarket)

- 역할과 특징

- 물체에서 방출되는 열(적외선)을 감지하여 이미지화

- 야간이나 악천후 시 보행자, 동물 등 열을 발산하는 물체의 탐지에 효과적

- 일반 카메라의 한계를 보완하는 보조 센서로 활용

- 장점

- 완전한 어둠 속에서도 열을 발산하는 물체(사람, 동물 등) 탐지 가능

- 안개, 연기, 먼지 등을 일부 투과하여 가시성 확보

- 일반 카메라와 함께 사용 시 객체 인식 정확도 향상

- 한계

- 일반 카메라에 비해 해상도가 낮음

- 유리나 물 등을 통과하지 못함

- 온도가 주변 환경과 비슷한 물체는 탐지하기 어려움

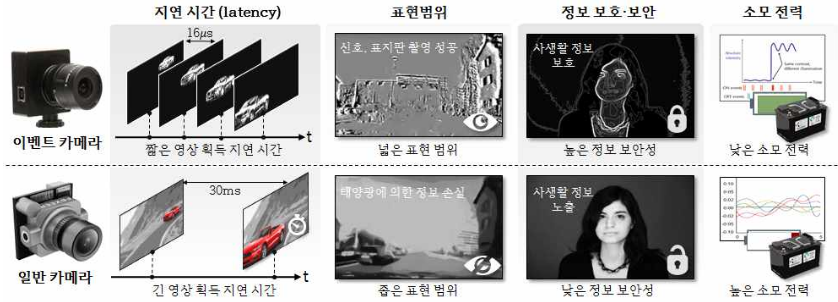

1.8. 이벤트 기반 카메라(Event Camera)

(그림출처: 이벤트 카메라 기반 시각 지능을 위한 컴퓨터 비전 알고리즘 연구 보고서, 2022, KAIST)

- 역할과 특징

- 전통적인 프레임 기반 카메라와 달리, 픽셀 단위로 밝기 변화가 발생할 때만 데이터 생성

- 매우 빠른 움직임도 놓치지 않고 포착 가능

- 넓은 동적 범위(Dynamic Range)

- 자율주행에서 빠른 움직임 감지, 저조도 환경에서의 인식 등에 활용

- 장점

- 매우 낮은 지연 시간(~마이크로초 단위)으로 빠른 움직임 포착

- 일반 카메라보다 훨씬 넓은 동적 범위(140dB 이상)로 다양한 조명 환경에 강인함

- 데이터 효율성이 높아 처리 부하 감소

- 한계

- 기존 컴퓨터 비전 알고리즘을 그대로 적용하기 어려움

- 정적 장면에서는 정보를 거의 생성하지 않음

- 아직 상대적으로 신기술로 비용이 높고 개발 중인 부분이 많음

1.9 휠 인코더 및 차량 내부 센서

휠 인코더(사진출처: 가치창조기술 온라인) 자이로 가속도 센서(사진출처: 디바이스마트)

- 역할과 특징

- 차량 바퀴의 회전을 측정하여 이동 거리와 속도 계산

- 차량 내부의 다양한 센서(조향각 센서, 가속도계, 자이로스코프 등)와 함께 차량 상태 모니터링

- 자율주행의 정밀한 제어와 위치 추정을 위한 기본 데이터 제공

- 장점

- 외부 환경에 영향 받지 않고 차량의 움직임 정보 제공

- 짧은 거리에서의 정확한 위치 변화 측정 가능

- 다른 센서 데이터의 보정 및 검증에 활용

- 한계

- 바퀴 미끄러짐 등으로 인한 오차 발생

- 장거리 주행 시 오차 누적

- 절대 위치가 아닌 상대적 위치 변화만 측정 가능

2. 센서 퓨전(Sensor Fusion)

2.1 센서 퓨전이란?

- 다양한 센서들의 데이터를 실시간으로 융합(센서 퓨전)하여 각 센서의 한계를 상호 보완하고 더 정확하고 안정적인 환경 인식을 수행

2.2 센서 퓨전 기법

- 칼만 필터(Kalman Filter)

- 다양한 센서 데이터의 불확실성을 고려하여 최적의 상태 추정을 제공함

- 특히 선형 시스템에서 뛰어난 성능을 발휘함

- GNSS/IMU 데이터 융합에 널리 사용됨

- 파티클 필터(Particle Filter)

- 비선형적인 문제에 효과적으로 대응할 수 있는 확률적 접근 방식

- 특히 차량의 전역 위치 추정(Global Localization)과 같이 불확실성이 큰 환경에서 강점을 보임

- 딥러닝 기반 센서 퓨전 (Deep Learning-based Sensor Fusion)

- 딥러닝 모델이 직접 여러 센서(카메라, 라이다 등)의 원시 데이터를 입력받아 고차원의 특징을 추출하고 융합하여

- 객체 탐지, 환경 인식 등 복합적인 작업을 수행

- PointPillars, F-PointNet 등과 같은 네트워크 구조가 대표적

- 기존 필터 기반 방식보다 복잡한 비선형 관계를 학습하고 더 높은 정확도를 달성할 수 있음

2.3 센서 퓨전을 통한 시너지 효과 예시

- 카메라 + 라이다

- 카메라가 제공하는 풍부한 색상 및 텍스처 정보와 라이다가 제공하는 정밀한 3D 거리 정보를 융합하여

- 객체를 정확히 인식하고, 거리까지 파악할 수 있어 객체 탐지 성능을 비약적으로 향상

- 악천후 시 카메라 성능이 저하될 때 라이다가 보완하고, 라이다가 감지하기 어려운 투명한 물체는 카메라가 보완하는 식

- 레이더 + 카메라

- 레이더가 악천후 및 먼 거리에서 물체의 속도를 정확히 측정하고,

- 카메라가 그 물체의 종류와 형태를 식별하는 방식으로 서로의 약점을 보완

- 자율주행 자동차는 단순히 하나의 센서에 의존하는 것이 아니라, 여러 종류의 센서가 각자의 강점을 살리면서 상호 보완적으로 작동하고, 이 데이터를 인공지능이 융합 분석하여 주변 환경을 360도로 완벽하게 이해하고자 함

- 이러한 다중 센서 퓨전 기술의 발전이 자율주행의 안전성과 신뢰도를 높이는 핵심 동력이라고 할 수 있음